Технологии как известно не стоят на месте, и сегодня мы имеем возможность даже бесплатно использовать их для своего комфорта в повседневной жизни.

Но все ли из тех технологий, которые мы сегодня используем на бесплатной или платной основе, в действительности соответствует нашим представлениям о конфиденциальности и правах человека?

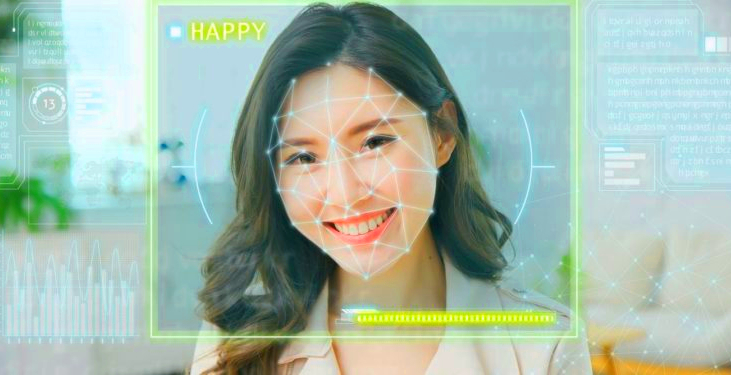

Для примера представьте, что вы на собеседовании. Когда вы отвечаете на вопросы рекрутера, система искусственного интеллекта (ИИ) сканирует ваше лицо , оценивая нервозность , сочувствие и надежность.

Для когото это может звучать как научная фантастика, но эти системы изобрели не вчера и они все чаще используются в повседневности, и часто без ведома или согласия людей.

Технология распознавания эмоций (ERT) на самом деле является быстрорастущей многомиллиардной отраслью, целью которой является использование ИИ для обнаружения эмоций по мимике. Тем не менее, наука, лежащая в основе систем распознавания эмоций очень противоречива, а в самой системе ERT интегрированы различные «предубеждения».

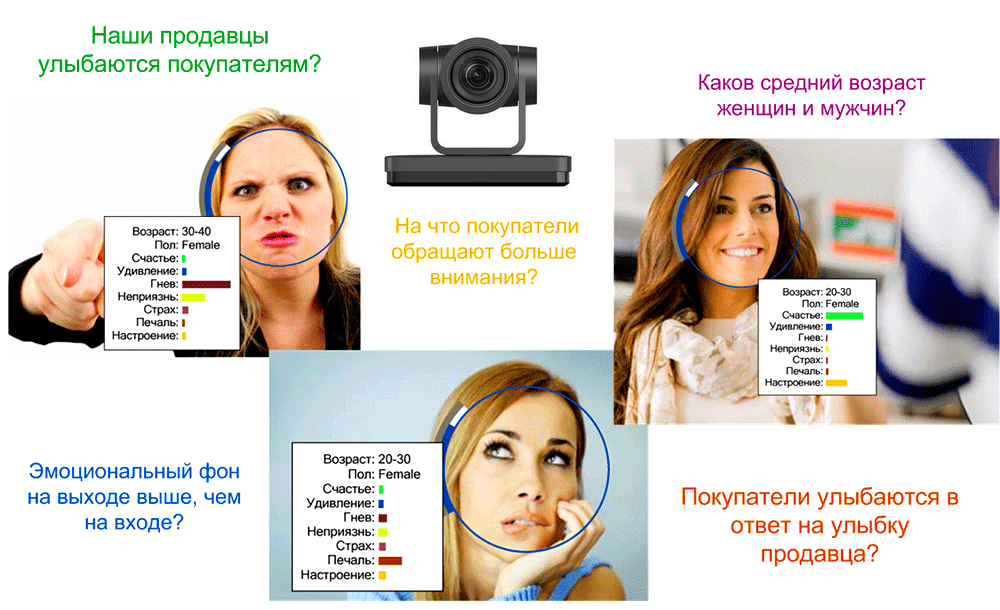

Многие компании используют ERT для проверки реакции потребителей на их продукты, от хлопьев до видеоигр.

Но эту технологию также можно использовать в ситуациях с гораздо более высокими ставками, например, при приеме на работу, службой безопасности аэропорта, чтобы отмечать лица как разоблачающие обман или страх, при пограничном контроле, в полицейской службе для выявления «опасных людей», или в системе образования для отслеживания активности школьников и студентов.

Но как многим уже известно, в последнее время эти технологии всё чаще начинают использоваться спец.службами, с целью мониторинга и контроля протестных демонстраций и митингов на предмет проявления экстремизма и агрессивного поведения.

Лично мне тяжело представить себе протестную демонстрацию или митинг, с радостными и улыбающимися лицами протестующих против продвижения законов нарушающих права человека, или же счастливые лица протестующих против деструктивных действий местных властей или правительства.

Шаткая научная основа технологии ERT

К счастью, технология распознавания лиц всё больше и больше привлекает внимание общественности.

Исследовательская группа, управляющая ImageNet, одним из крупнейших и наиболее важных наборов данных, используемых для обучения распознаванию лиц, недавно была вынуждена размыть 1,5 миллиона изображений из соображений конфиденциальности.

Разоблачения алгоритмической предвзятости и дискриминационных наборов данных в технологии распознавания лиц привели к тому, что крупные технологические компании, включая Microsoft, Amazon и IBM, прекратили их продажи.

Эта технология сталкивается с юридическими проблемами в связи с ее использованием и в полиции Великобритании.

В ЕС коалиция из более чем 40 организаций гражданского общества призвала полностью запретить технологию распознавания лиц.

Как и другие формы распознавания лиц, ERT поднимает вопросы о предвзятости, конфиденциальности и массовом наблюдении.

Но ERT вызывает и другое беспокойство: наука об эмоциях, стоящая за ней, слишком противоречива.

Большинство ERT основано на теории «основных эмоций», согласно которой эмоции имеют биологическую структуру и выражаются одинаково людьми повсюду.

Однако у большинства исследователей это вызывает всё большие сомнения.

Исследования в области антропологии показывают, что эмоции по-разному выражаются в разных культурах и обществах.

В 2019 году Ассоциация психологических наук провела обзор доказательств и пришла к выводу об отсутствии научной поддержки общепринятого предположения о том, что эмоциональное состояние человека можно легко определить по мимике его лица.

Кроме того, как и другие формы технологии распознавания лиц, ERT кодируется с расовым уклоном.

Исследование показало, что системы постоянно воспринимают лица чернокожих как более злые и агрессивные, чем лица белых, независимо от выражения лица. Хотя изучение расовых предубеждений в ERT не так много, расовые предубеждения в других видах технологий распознавания лиц уже хорошо задокументированы.

По словам исследователя искусственного интеллекта Деборы Раджи в интервью MIT Technology Review , эта технология может причинить вред людям двумя способами :

«Один из способов — не работать: в силу того, что у цветных людей выше процент ошибок, это подвергает их большему риску. Вторая ситуация — когда это действительно работает — когда у вас есть идеальная система распознавания лиц, но ее легко использовать против разных сообществ, чтобы преследовать их ».

Таким образом, даже если технология распознавания лиц может быть идеально беспристрастной и максимально точной для всех людей, она все равно может быть несправедливой.

Мы видим эти несопоставимые эффекты, когда технология распознавания лиц используется в полицейских и судебных системах, которые уже являются дискриминационными и вредными для темнокожих.

Технологии могут быть опасными, если они не работают должным образом. И они также могут быть опасны, когда отлично работают в несовершенном мире.

Ученые из Леверхалмского центра изучения, который находится при Кембриджском университете, считают, что системы ERT могут быть опасными. Они даже провели эксперимент, в ходе которого выяснили, что система распознавания лиц имеет множественные недочеты.

Когда дело доходит до ERT, необходимо для начала изучить противоречивую науку об эмоциях, интегририруемую в эти системы.

Но прежде всего мы должны спросить себя:

Даже если бы ERT и можно было идеально спроектировать так, чтобы точно считывать внутренние чувства и эмоции каждого из нас, хотим ли мы с вами такого интимного наблюдения и анализа личности в нашей повседневной жизни?

Вот и известная многим компания Zoom, которая во время «фейкдемии Ковид» стала лидером отрасли в области видеозвонков, отличилась посягательством на права конфиденциальности человека.

«Фейкдемия Ковид» сделала видеоконференции гораздо более распространёнными по всему миру.

Однако продавцам было трудно определить, насколько потенциальные клиенты восприимчивы к их товарам и услугам, не имея возможности прочитать язык их тела через экран.

В результате компании начали использовать технологии, позволяющие анализировать настроение людей во время видеозаписи их беседы, а также и видеоразговора интегрируя эти технологии в свои продукты и платформы, и Zoom планирует предоставить такую же услугу.

В связи с чем, 27 правозащитных организаций призвали Zoom отменить развертывание инвазивного и предвзятого программного обеспечения, и прекратить разработку алгоритмов искусственного интеллекта для отслеживания и анализа эмоций(ERT), релиз которого запланирован на 20 мая 2022 года.

11 мая 2022 г эти организации отправили письмо в ответ на новости, опубликованные Protocol, в которых Zoom отмечается как развивающая технологии отслеживания и анализа эмоций(ERT).

Это часть более крупного материала, в котором рассматривается, как компании начали использовать искусственный интеллект для определения эмоционального состояния потенциального клиента во время видеозвонков по продажам.

По мнению экспертов это программное обеспечение является дискриминационным, манипулятивным, потенциально опасным и основано на предположениях, что все люди используют одни и те же выражения лица, модели голоса и язык тела.

Это по своей сути предвзято и связано с изначально расистскими и дискриминационными практиками, такими как физиогномика.

Использование Zoom этого программного обеспечения подтверждает псевдонауку анализа эмоций, которая, по мнению экспертов, не работает. Выражения лица могут значительно различаться и часто не связаны с эмоциями, скрывающимися за ними, так что даже люди часто не в состоянии точно расшифровать их.

В 2021 году проект под руководством профессора Кембриджского университета Алексы Хагерти показал, насколько ограничены возможности ИИ, распознающего эмоции, и как легко их обмануть.

Предыдущие исследования также показали, что программы распознавания эмоций проваливают тест на расовую предвзятость и с трудом считывают лица темнокожих.

Оценив все эти факторы, эти oрганизации, представляющие широкие круги избирателей, призвали Zoom публично взять на себя обязательство прекратить использование этого программного обеспечения.

Ссылка на их письмо

Подписавшие выступили с заявлениями.

Предлагаем вашему вниманию некоторые из них:

“Если Zoom продвинется с этими планами, эта функция будет дискриминировать людей определенных этнических групп и людей с ограниченными возможностями, жестко кодируя стереотипы в миллионах устройств. Помимо получения прибыли и предоставления предприятиям возможности извлекать из них выгоду, эта технология может найти гораздо более зловещее и карательное применение.

Нетрудно представить, что работодатели и академические учреждения используют анализ эмоций, чтобы дисциплинировать работников и студентов, которые, как считается, “выражают неправильные эмоции”, основываясь на ошибочном ИИ”. – Кейтлин Сили Джордж, директор кампании и операций Fight for the Future.

Крупные и влиятельные технологические компании, такие как Zoom, теперь обладают огромной глобальной властью (превышающей власть многих национальных правительств), и с этой властью приходит ответственность уважать и не нарушать частную жизнь, равенство и другие права человека.

Широкое внедрение Zoom искусственного интеллекта для рутинного “распознавания эмоций” будет представлять собой нереалистичное киберутопическое невнимание к возникающим рискам — особенно для и без того маргинализированных лиц и групп — и будет не только фактически неточным, вводящим в заблуждение, но и дискриминационным, навязчивым и совершенно жутким ”. – Чип Питтс, председатель Advocacy for Principled Action in Government

“Принятие мусорной науки об обнаружении эмоций на платформе Zoom было бы огромной ошибкой. Нет никаких достоверных доказательств того, что машина может точно оценить чье-то эмоциональное состояние, и много доказательств того, что универсальные предположения о “нормальности” не отражают человеческое разнообразие и не наказывают «аутгруппы» за различия. Не говоря уже о том, что бизнес работодателя или учителя — это то, как человек выполняет свою роль и поддерживает отношения.

Это выбор людей, раскрывать чувства и проблемы в других аспектах жизни человека – и так должно оставаться” – Трейси Розенберг, Oakland Privacy

“В наш век безудержных манипуляций и вреда, наносимого технологиями и медиа-коммуникационными платформами, мы в OICD призываем Zoom проявить лидерство с помощью разумной осторожности, вместо внедрения необдуманных новых технологических функций, таких как ERT, которые могут нанести ущерб самоопределению и развитию идентичности уязвимых меньшинств, путем укоренения предубеждений и стереотипов.” – Д-р Брюс Уайт, Исполнительный директор OICD (Organization for Identity and Cultural Development)

“Наши эмоциональные состояния и наши самые сокровенные мысли должны быть свободны от наблюдения. Программное обеспечение для распознавания эмоций снова и снова демонстрировалось как ненаучный, упрощенный мусор, дискриминирующий маргинализированные группы, но даже если бы оно работало и могло точно идентифицировать наши эмоции, ему не место в нашем обществе, и уж точно не на наших рабочих встречах, наших онлайн-уроках и других человеческих взаимодействий, для которых такие компании, как Zoom, предоставляют платформу ”. – Даниэль Лойфер, старший политический аналитик Access Now.

Организации по защите прав человека надеются, что это письмо (вместе со страницей кампании, где все желающие люди могут подписать петицию в Zoom) заставит компанию отказаться от планов по сбору эмоциональных данных пользователей, поскольку это является нарушением их конфиденциальности и прав человека в целом.

Они также отмечают, что эта технология основана на лженауке, и призывают лидера отрасли в области видеозвонков убедиться, что она не станет стандартом.

Ниже предоставлен список организаций, которые подписались под письмом:

Access Now

ACLU

Advocacy for Principled Action in Government

Defending Rights & Dissent

Državljan D / Citizen D

Electronic Privacy Information Center (EPIC)

Fight for the Future

Fundación InternetBolivia.org

Global Voices

ΗΟΜΟ DIGITALIS

Jobs With Justice

Kairos

Muslim Justice League

Neon Law Foundation

Oakland Privacy

Open MIC

OpenMedia

Organization for Identity and Cultural Development

PDX Privacy

PEN America

Ranking Digital Rights

RootsAction.org

Secure Justice

Simply Secure

Surveillance Technology Oversight Project

Taraaz

United We Dream

X-Lab

источник

Также вы можете изучить предыдущую статью о технологиях распознавания лиц, их уязвимостях, и как люди в разных странах обходят и обманывают эти системы.