Введение

- Дипфейк — это метод создания фотографий и видеороликов с помощью алгоритмов глубокого обучения. Технология позволяет в существующих медиаданных заменять лицо человека на совершенно другое.

- В интернете обнаружено по меньшей мере 85 000 подделок, созданных с применением ИИ. По словам экспертов, их количество удваивается раз в шесть месяцев.

- Помимо дезинформации, запугивания и преследования, дипфейки используются в сфере развлечений, синтезирования данных и восстановления голоса.

Что такое дипфейк?

Дипфейк — это технология синтезирования медиаданных, на которых лицо человека на существующих фото или видео заменяется лицом другого человека.

При изготовлении подделок используются методы «искусственного интеллекта», а если быть точнее, то- методы машинного обучения и нейронных сетей.

Название технологии произошло от сочетания английских терминов deep learning (глубокое обучение) и fake (подделка).

Для чего создаются дипфейки?

Дипфейки в основном используются для информационных атак, создания пародий и сатиры.

В 2018 году американский режиссер Джордан Пил и издание BuzzFeed опубликовали якобы обращение бывшего президента США Барака Обамы, в котором он назвал Дональда Трампа «засранцем». Ролик создали с помощью приложения FaceApp и графического редактора Adobe After Effects. Режиссер и журналисты хотели продемонстрировать, как в будущем могут выглядеть фейковые новости.

Есть и реальные случаи. К примеру 16 марта 2022 года в социальных сетях распространилось фейковое видео президента Украины Владимира Зеленского, в котором глава государства «призывает народ сдаться».

Об этом сообщает Sky News.

Пользователи сети быстро определили подделку из-за ее низкого качества. В клипе голова Зеленского слишком велика для тела, к которому она прикреплена цифровым способом. В некоторых кадрах она освещена по-разному и расположена под неестественным углом, отметили пользователи сети.

Вокруг головы также заметен более высокий уровень пикселизации по сравнению с телом.

Кроме этого, на поддельном видео голос Зеленского оказался глубже и медленнее, чем его нормальная речь.

Настоящий Зеленский назвал ролик «детской провокацией» и опроверг все сделанные в нем заявления.

В мае того же года мошенники распространили дипфейк Илона Маска, в котором тот «призывает инвестировать» в очевидный скам.

В фейковом ролике глава Tesla и SpaceX «рассказывает» о новом проекте, якобы приносящем пользователям «30% дивидендов каждый день до конца их жизни».

Мошенничество организовала фейковая торговая платформа BitVex.

«Голос» Маска сделали настолько механическим, что не заметить это просто невозможно.

Сам миллиардер также подтвердил, что видео – подделка.

«Фу. Конечно же это не я», — написал он.

Сооснователь и разработчик криптовалюты (мемкоина) Dogecoin Билли Маркус также прокомментировал низкое качество вирусного видео.

«Тот, кто достаточно глуп, чтобы инвестировать в это, заслуживает потери своих денег.

В то же время мошенники заслуживают провести свою жизнь в тюрьме», — добавил он.

Опубликовавший ролик YouTube-канал имел свыше 100 000 подписчиков, а до удаления аккаунта видео посмотрели свыше 90 000 раз. Сколько людей повелись на скам(мошенничество), неизвестно.

Многие из вас скорее всего уже знакомы с боле ранними дипфейками, например такими как поздравление кор. Елизаветы в Британии.

А также очень познавательные видеоролики с наглядными примерами из Телеграм канала — «Фeйк-НОуЮз-СоVmedу-Stуlе»

Первый пример

Второй пример

Также существует множество приложений для развлечений, создающих дипфейки.

В начале 2020 года широкую известность получило приложение Reface, использующее технологию дипфейк для создания коротких видеороликов с наложением буквально любого лица на широкий спектр видео и гиф-анимации.

Новые методы позволяют неквалифицированным людям делать дипфейки с помощью нескольких фотографий.

По словам экспертов, количество подобного контента удваивается каждые шесть месяцев. Вероятно, поддельные видео распространятся за пределы мира знаменитостей, чтобы подпитывать порноместь.

Что можно подделать?

Дипфейк-технология может создавать не только убедительные видео, но и полностью вымышленные фотографии с нуля.

В 2019 году некая Мэйзи Кинсли завела профили в LinkedIn и Twitter, в которых она назвалась журналисткой Bloomberg. «Журналистка» связывалась с сотрудниками компании Tesla и выпытывала различную информацию.

Позже выяснилось, что это дипфейк. Никаких убедительных фактов, связывающих ее с изданием, соцсети не содержали, а фотография профиля была явно сгенерирована искусственным интеллектом.

В 2021 году ForkLog HUB провел эксперимент, создав виртуального персонажа Н. Г. Адамчука, который «писал» для платформы «рассуждения о рынке» криптовалют. Тексты были сгенерированы с помощью большой языковой модели GPT-2. Аватар создан сервисом This Person Does not Exist.

Аудио также можно сфальсифицировать для создания «голосовых клонов» публичных лиц.

В Объединенных Арабских Эмиратах мошенники подделали голос руководителя крупной компании и убедили банковского работника перевести $35 млн на их счета. Об этом пишет Forbes.

Согласно судебному документу, в январе 2020 года менеджер одного из филиалов банка ответил на телефонный звонок якобы владельца крупной компании. Так как сотрудник ранее общался с ним, ему не удалось распознать дипфейк по голосу.

Мошенники использовали фальшивые электронные письма от имени компании и ее юриста. Это позволило им убедить сотрудника банка в том, что предприятие находится в процессе заключения сделки на $35 млн. Менеджер последовательно выполнял указания звонящего и перевел средства на несколько указанных счетов.

По данным правоохранительных органов, мошенники использовали программу для клонирования голоса Deep Voice. Следователи считают, что в схеме участвовали по меньшей мере 17 человек, а банковские счета, на которые ушли деньги, разбросаны по всему миру. Два из них открыты в Соединенных Штатах, что позволило властям ОАЭ привлечь к расследованию американских правоохранителей.

Аналогичный случай произошел в 2019 году с британской энергетической компанией. Мошенникам удалось украсть около $243 000, выдав себя за директора фирмы с помощью поддельного голоса.

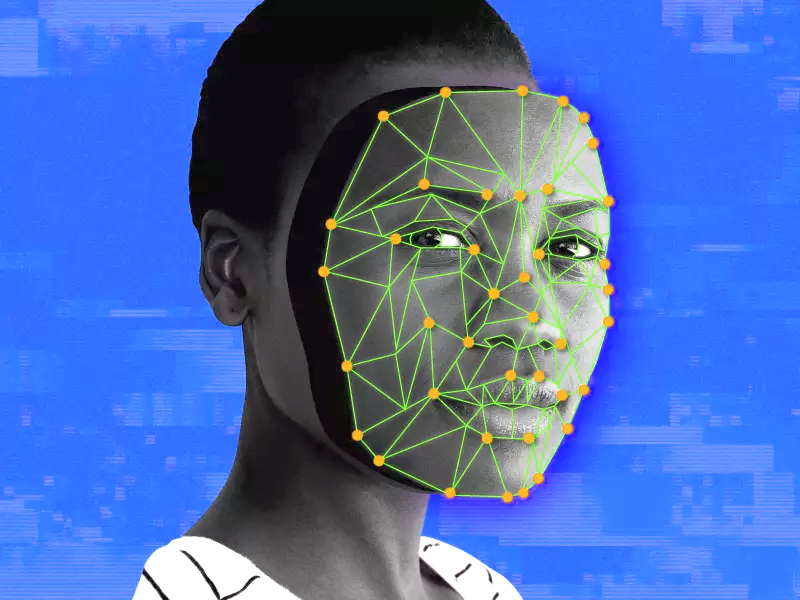

Как создаются дипфейки?

Для создания дипфейков необходим большой набор данных лиц двух людей.

Датасет анализируется ИИ-кодировщиком, который находит сходства между ними и сжимает изображения.

Затем декодер обучают восстанавливать лица из сжатых кадров. Для каждого человека используется отдельный алгоритм. Чтобы поменять лица местами, необходимо загрузить сжатые данные в «неправильный» декодер.

Например, изображения человека А подаются в декодер, обученный на человеке Б. Алгоритм реконструирует лицо человека Б с выражением лица А.

Для получения качественного результата для видео алгоритм должен обработать таким образом каждый кадр.

Другой способ создания дипфейков — использование генеративно-состязательных нейросетей (GAN). Подобный метод используется в сервисах вроде This Person Does not Exist.

Кто создает дипфейки?

Дипфейки могут создавать академические и коммерческие исследователи, инженеры машинного обучения, энтузиасты-любители, студии визуальных эффектов и режиссеры.

Также благодаря популярным приложениям вроде Reface или FaceApp любой владелец смартфона может сделать поддельный снимок или видео.

Правительства также могут пользоваться технологией, например, в рамках своих онлайн-стратегий по дискредитации и подрыву экстремистских групп или установлению контактов с целевыми лицами.

В 2019 году журналисты обнаружили профиль некой Кэти Джонс в LinkedIn, который оказался дипфейком. Тогда в Национальном центре контрразведки и безопасности США сообщили, что иностранные шпионы регулярно используют поддельные профили в соцсетях для слежки за американскими целями. В частности, ведомство обвинило Китай в ведении «массового» шпионажа через LinkedIn.

В 2022 году южнокорейские инженеры создали дипфейк кандидата в президенты Юн Сок Еля для привлечения молодых избирателей в преддверии выборов 9 марта 2022 года.

Какие технологии используются в изготовлении дипфейков?

Большинство подделок создаются на высокопроизводительных настольных компьютерах с мощными видеокартами или в облаке.

Также требуется опыт, не в последнюю очередь для исправления законченных видео и устранения визуальных дефектов.

Однако сейчас доступно множество инструментов, помогающих людям делать дипфейки как в облаке, так и прямо на смартфоне.

К вышеупомянутым Reface и FaceApp можно добавить Zao, которое накладывает лица пользователей на персонажей фильмов и телепередач.

Как распознать дипфейк?

В большинстве случаев поддельные фото и видео низкого качества.

Распознать дипфейк можно по неморгающим глазам, плохой синхронизации речи и губ, пятнистому оттенку кожи. По краям транспонированных граней может наблюдаться мерцание и пикселизация. Мелкие детали вроде волос особенно сложно качественно прорисовать.

Плохо перенесенные украшения и зубы также могут свидетельствовать о подделке. Следует обратить внимание и на непоследовательное освещение, а также отражения на радужной оболочке глаз.

Техгиганты сформировали альянс для противодействия дипфейкам

Альянс IT-компаний C2PA разработает стандарт подтверждения подлинности изображений и видео в интернете. Среди участников консорциума Adobe, Microsoft, Intel, Twitter, Sony, Nikon, BBC и ARM.

По данным альянса, внедрение открытого стандарта предотвратит распространение дипфейков. Многие из механизмов проверки подлинности появятся в 2022 году, а через пару лет сформируется экосистема для контроля правдивости фото и видео на всех этапах их жизненного цикла, заявили в Adobe.

Технический стандарт будет гарантировать отсутствие вмешательства в контент с помощью технологии распределенных реестров. В Adobe утверждают, что альянсу предстоит пройти долгий путь, прежде чем все платформы смогут внедрить эффективные механизмы проверки подлинности материалов.

В 2020 году в преддверии выборов в США Facebook запретил дипфейковые видео, которые могут ввести пользователей в заблуждение.

В мае 2022 года Google ограничила возможность обучать модели для создания дипфейков в облачной среде Colab.

В чем опасность дипфейков?

Помимо дезинформации, преследований, запугиваний и унижений, дипфейки могут подорвать доверие общества к конкретным событиям.

По мнению профессора и эксперта в области интернет-права Университете Ньюкасла Лилиан Эдвардс, проблема заключается не столько в подделках, сколько в отрицании реальных фактов.

По мере распространения технологии, дипфейки могут создать угрозу для правосудия, где фальсифицируемые события могут выдаваться за реальные.

Также они представляют угрозу для личной безопасности.

Дипфейки уже умеют имитировать биометрические данные и обманывать системы распознавания лиц, голоса или походки.

Чем дипфейки могут быть полезны?

Помимо угроз, дипфейки могут оказаться и полезными.

Технологию активно используют в развлекательных целях. Например, лондонский стартап Flawless разработал искусственный интеллект для синхронизации губ актеров и звуковой дорожки при дублировании фильмов на разные языки.

В июле 2021 года авторы документального фильма об известном шеф-поваре Энтони Бурдене, умершем в 2018 году, использовали дипфейк для озвучивания его цитат.

Кроме этого, технология может помочь людям вернуть голос, потерянный из-за болезни.

Также дипфейки используют для создания синтетических наборов данных. Это избавляет инженеров от необходимости собирать фотографии реальных людей и получать разрешения на их использование.

Существует ещё огромное количество примеров дипфейков, которые не трудно найти на просторах интернета, перечисляя которые эта статья превратится в «лонгрид«, но как мне кажется эта технология всё же требует пристального внимания и самостоятельного изучения.

Итог Дорогие читатели, вы подведёте сами.

Хочется лишь добавить, что в нынешнем мире, у нас всё меньше и меньше возможности доверять всему тому, что мы видим и слышим с экранов.